NVIDIA RTX PRO™ Sync

Sincronización NVIDIA RTX PRO

Visualizaciones perfectamente sincronizadas a cualquier escala

SINCRONIZACIÓN PERFECTA PARA SISTEMAS MULTIPANTALLA

NVIDIA RTX PRO™ Sync y las GPU NVIDIA Professional compatibles son compatibles con Windows 10, 11 y Linux, lo que proporciona un sistema robusto que te permite:

- Impulse soluciones multipantalla sincronizadas a gran escala utilizando plataformas de nivel empresarial a cualquier escala, desde señalización digital hasta experiencias a escala de edificios.

- Sincronice cientos de pantallas para crear soluciones más grandes que la vida real: desde vídeos hasta gráficos interactivos en 3D y todo lo demás.

- Despliegue en instalaciones punteras de misión crítica en todo el mundo

Configuración y características

Sincronización NVIDIA RTX PRO

| Número máximo de GPU por tarjeta de sincronización | 4 | ||||

| Número máximo de tarjetas de sincronización por sistema | 2 | ||||

| Número máximo de GPU por sistema | 8 | ||||

| Número máximo de pantallas o proyectores por sistema | 32 | ||||

| Número máximo de pantallas o proyectores con NVIDIA Mosaic™ | 32 | ||||

| Compatibilidad con pantallas estereoscópicas | SI | ||||

| Soporte superpuesto para proyectores | SI | ||||

| Compatibilidad con Windows Management Instrumentation (WMI) | SI | ||||

La solución NVIDIA RTX PRO Sync es compatible con las GPU profesionales NVIDIA RTX™ y NVIDIA Data Center

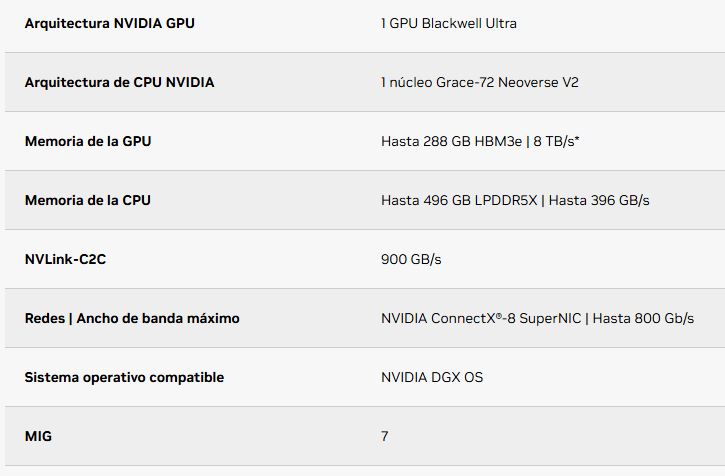

| Arquitectura | Producto | Sistema operativo |

| Blackwell Generación |

NVIDIA RTX PRO 6000 Blackwell Workstation Edition NVIDIA RTX PRO 6000 Blackwell Max-Q Workstation Edition NVIDIA RTX PRO 5000 Blackwell NVIDIA RTX PRO 4500 Blackwell NVIDIA RTX PRO 4000 Blackwell |

Windows 11 Windows 10 Linux |

| Ada Generación |

NVIDIA RTX 6000 Ada Generation NVIDIA RTX 5000 Ada Generation NVIDIA RTX 4500 Ada Generation NVIDIA RTX 4000 Ada Generation NVIDIA RTX 4000 SFF Ada Generation NIVIDA L40 NVIDIA L40S |

Windows 11 Windows 10 Linux |

| Ampere Generación |

NVIDIA RTX A6000 NVIDIA RTX A5500 NVIDIA RTX A5000 NVIDIA RTX A4500 NVIDIA RTX A4000 NVIDIA A40 |

Windows 11 Windows 10 Linux |

| Turing Generación |

NVIDIA Quadro RTX 8000 NVIDIA Quadro RTX 6000 NVIDIA Quadro RTX 5000 NVIDIA Quadro RTX 4000 |

Windows 11 Windows 10 Linux |

Versiones de Linux compatibles: Ubuntu, Red Hat, OpenSUSE, Fedora

Casos de uso y matriz vertical de NVIDIA RTX PRO Sync

| Caso práctico | Flujo de trabajo (prácticas en empresas) | Verticales | Características distintivas |

| Señalización digital y murales de vídeo | Publicidad en comercios Señalización corporativa Ferias comerciales |

Venta al por menor | Bajo consumo Factor de forma pequeño |

| Streaming de medios de comunicación y entretenimiento | Streaming de medios de comunicación y entretenimiento Entretenimiento basado en la localización Virtual Production Media Broadcast |

M&E | Superposición de proyecciones Soporte Warp Engine Reproducción 8K sin fisuras |

| Visualización de la sala de control | Sistemas para centrales nucleares Mercado financiero Sistemas de distribución de energía Sistemas de tránsito |

Energía Finanzas Sector público MFG |

Motor Warp Escalado de aplicaciones Aplicación mixta 2D/3D |

| Vehículos autónomos / Simuladores | Diseño Pared Sensor en bucle Drive & Flight Sim |

Sector público Auto MFG |

Motor Warp Escalado de aplicaciones Aplicación mixta 2D/3D |

| Pantallas interactivas | Publicidad en comercios VR Caves (Museos/Educación) |

Energía Finanzas Sector público MFG |

Escritorio único Reproducción 4K sin fisuras |