Rendimiento y Escalado Multi-GPU en Octane y Redshift con Geforce RTX

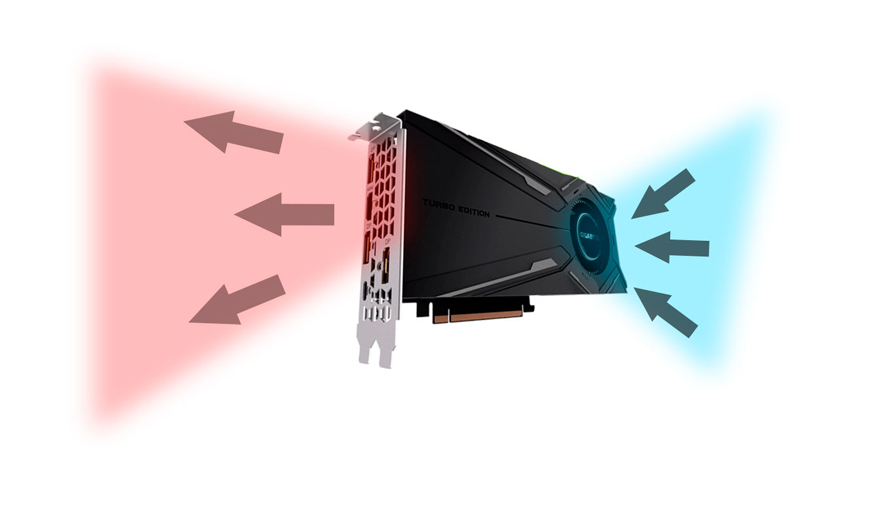

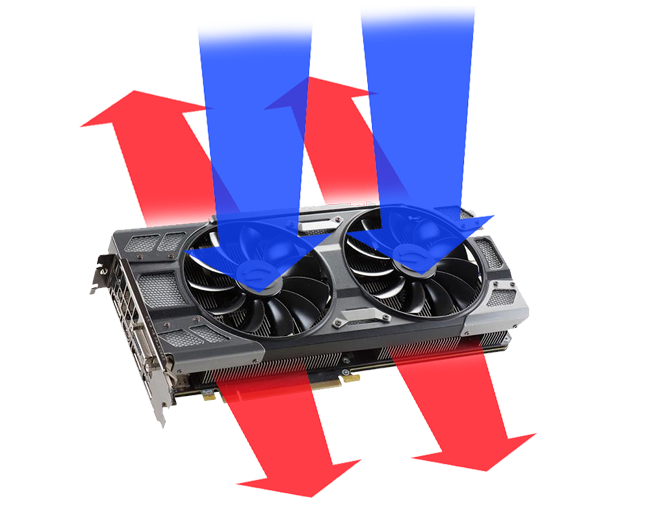

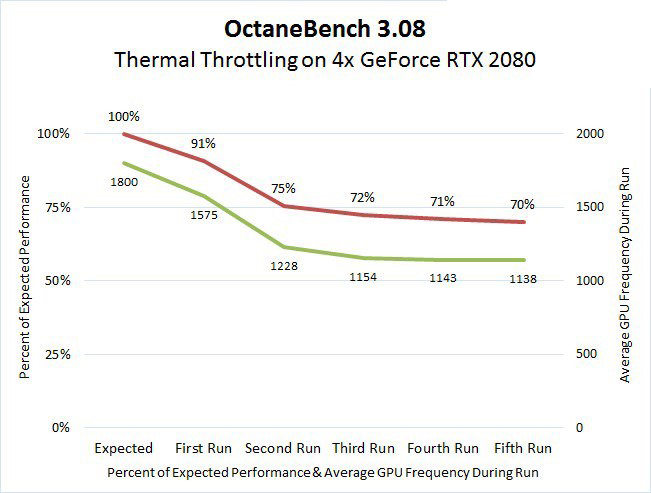

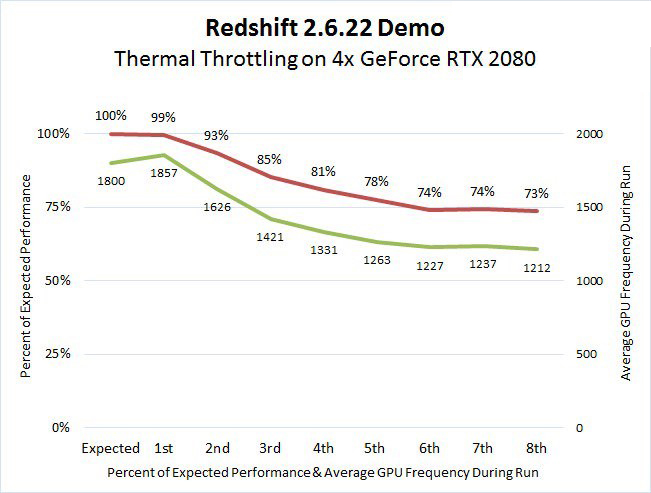

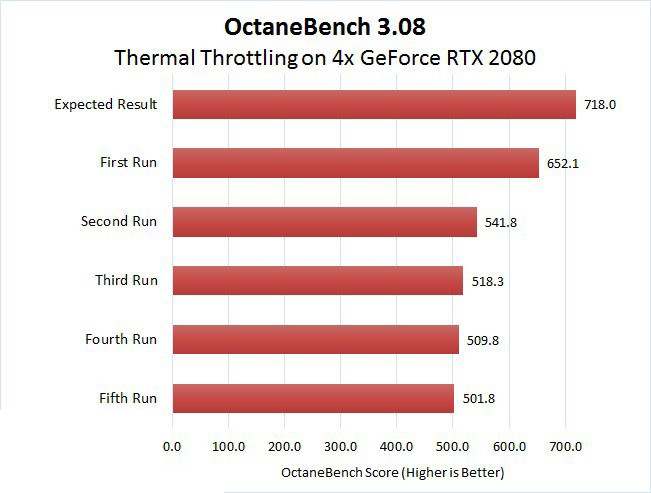

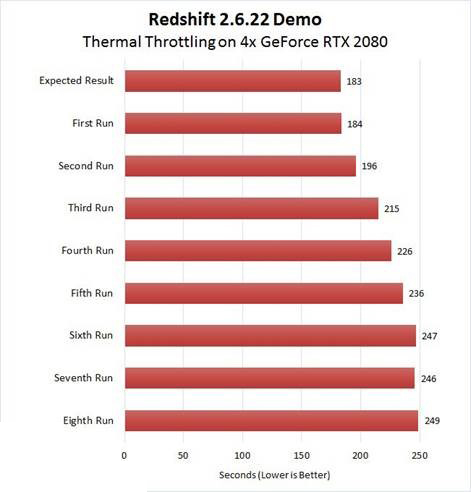

Anteriormente, nos dimos cuenta que en soluciones Multi-GPU con Geforce RTX cuando realizábamos tareas de render daba lugar a un sobrecalentamiento y a una reducción significativa del rendimiento, debido a la solución de doble/triple ventilador que NVIDIA ha adoptado como estándar en esta generación de tarjetas “Founders Edition», así como en distintos modelos de ensambladores que emplean estos sistemas en sus GPUs enfocadas al sector de consumo y/o gaming. En esta entrada de blog puedes consultar los resultados de las pruebas.

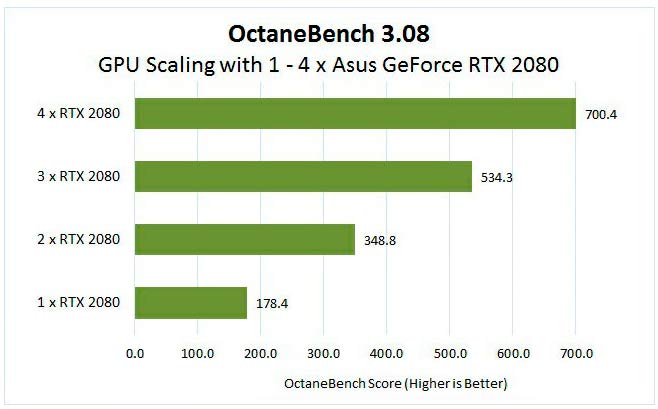

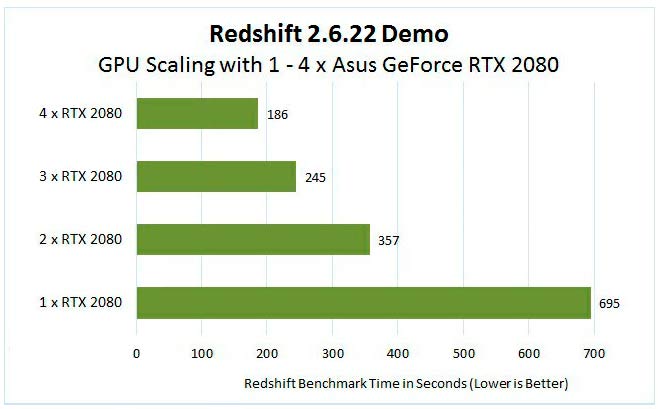

Ahora que fabricantes como ASUS emplean sistemas Blower para refrigerar sus GPUs, podemos comprobar en las siguientes pruebas como se resuelven los problemas de Thermal Throttling y averiguar qué tan bien escalan estas GPUs cuando usamos 1, 2, 3, o incluso 4 de ellas para renderizar, por ejemplo, en OctaneRender y Redshift, como podemos ver a continuación.

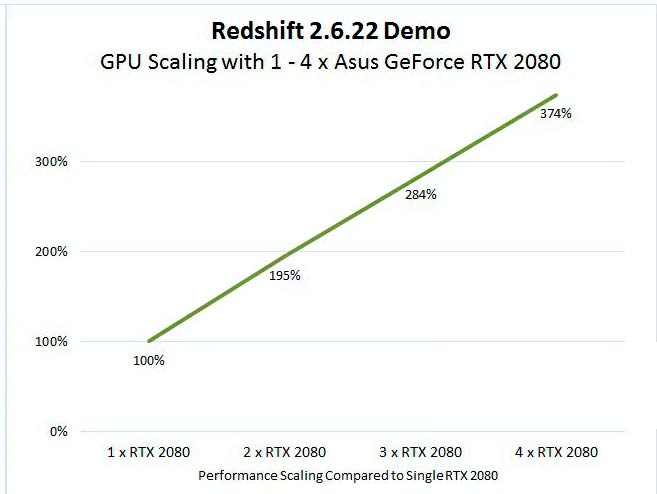

Lo primero que podemos ver en las siguientes tablas son los resultados de los benchmarks según el número de GPUs que usemos:

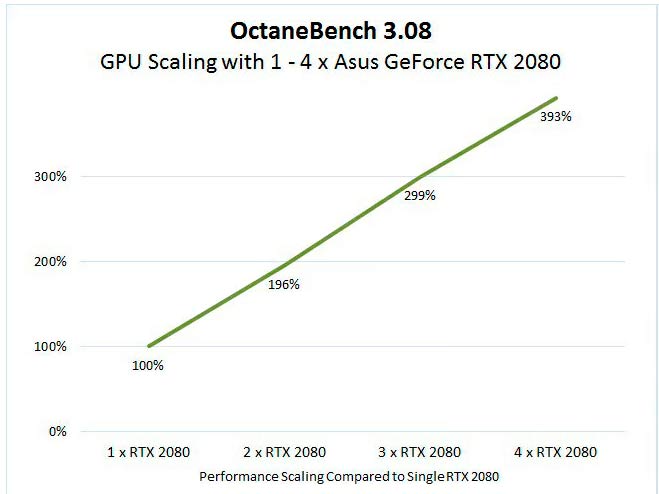

Y podemos comprobar fácilmente como las GPUs escalan de manera casi lineal cuando pasamos de una GPU a cuatro:

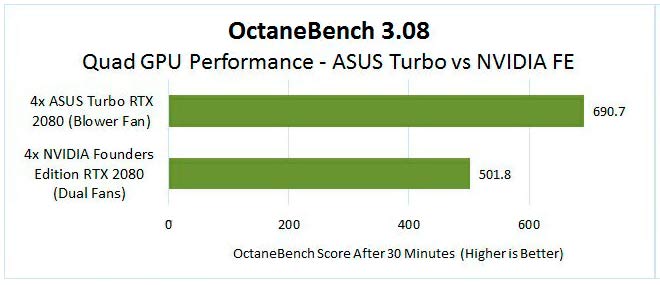

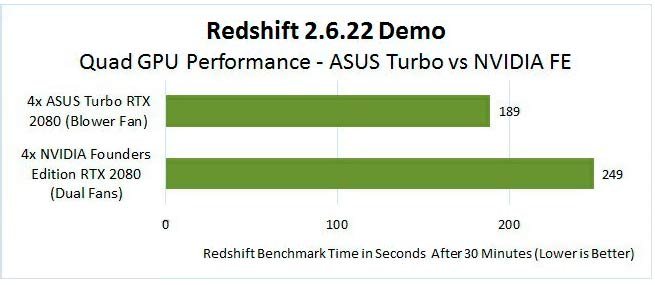

Sin embargo, estos resultados no nos dicen nada si no los comparamos con las pruebas realizadas con sistemas Multi-GPU empleando gráficas con sistemas de ventilación Dual Fan. Aquí podemos ver la diferencia:

Llegados a este punto podemos comprobar fácilmente como en solucionas Multi-GPU con sistemas de refrigeración Blower tenemos un rendimiento notablemente superior frente a soluciones de refrigeración basadas en doble o triple ventilador.

Te recordamos nuevamente que en Azken Muga empleamos GPUs con sistemas de refrigeración Blower para todas nuestras soluciones Multi-GPU, tanto en Workstations como en Servidores de alta densidad.

Para más información no dudes en contactar con nosotros