Azken Review: Programa ASUS CSM

En este artículo queremos hacer una review de dos productos realmente interesantes de Asus. En primer lugar, un software de gestión centralizada de IT para entornos datacenter, enterprise y PYME llamado ASUS Control Center y, por otro lado, la gama de placas base pertenecientes al programa CSM.

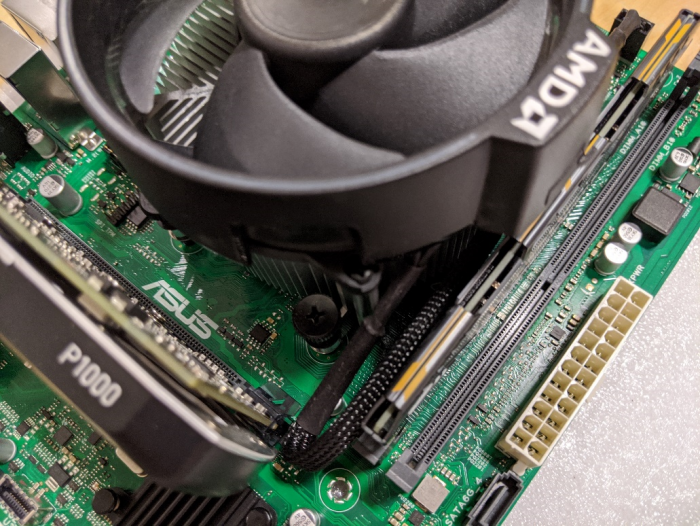

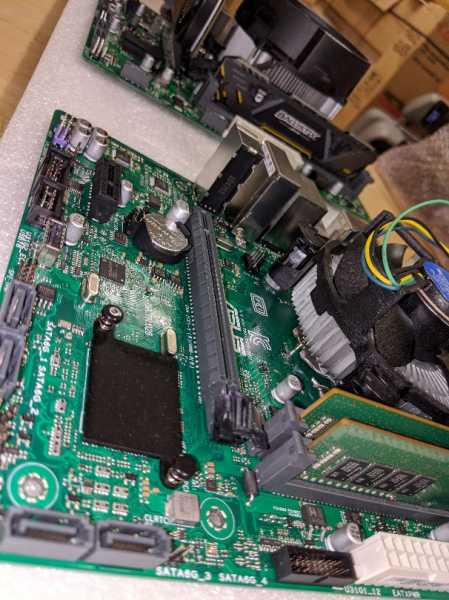

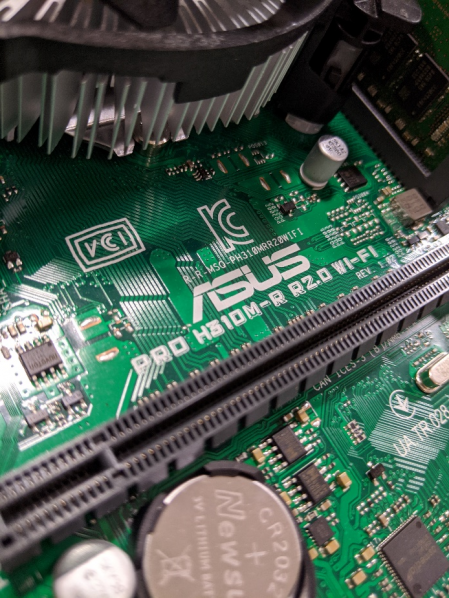

En nuestro entorno de pruebas y por gentileza de Asus hemos utilizado las placas base CSM modelos Asus PRO H310M-R R2.0WI-FI/CSM y Asus PRO A320M-RWI-FI/CSM. Estas placas son especialmente adecuadas para nuestro artículo ya que incluye una licencia de uso para ACC edición CSM.

Los productos pertenecientes al programa CSM están pensados para entornos empresariales y entre otras ventajas sobre la gama de productos de consumo, ofrecen un ciclo de vida de 36 meses, la máxima disponibilidad y notificación de cambios. Como nota adicional, Asus asegura que lleva en marcha más de 16 años en otros países con gran éxito.

En el caso del modelo Asus PRO H310M-R R2.0WI-FI/CSM, es una placa basada en un chipset H310 de Intel con soporte para procesadores hasta i7 de 8ª generación con gráficos integrados, en un formato Micro-ATX, con conectividad PCIe 3.0, Ethernet 1Gbit, Wifi Dual band integrado y Bluetooth 5.0. También incluye audio y soporte hasta 32GB de memoria DDR4.

En el caso de la placa Asus PRO A320M-RWI-FI/CSM, está basada en un chipset AMD 320 y socket AM4 con soporte para procesadores Ryzen de 3ª generación hasta 8 cores y gráficos integrados Radeon Vega. Igual que la anterior en un formato Micro-ATX, con conectividad PCIe 3.0, Ethernet 1Gbit, Wifi Dual band integrado y Bluetooth 5.0. También incluye audio y soporte hasta 32GB de memoria DDR4.

Pero lo que realmente diferencia a estos productos es que están especialmente dirigidas al sector profesional, a entornos IT empresarial y gama Enterprise. Por ejemplo, incluyen mecanismos de fiabilidad 24/7, recuperación automática de BIOS, registro de errores en BIOS, una construcción especialmente sólida anti-humedad y corrosión. También disponen de garantía de disponibilidad a largo plazo y soporte postventa mejorado.

Asus Control Center

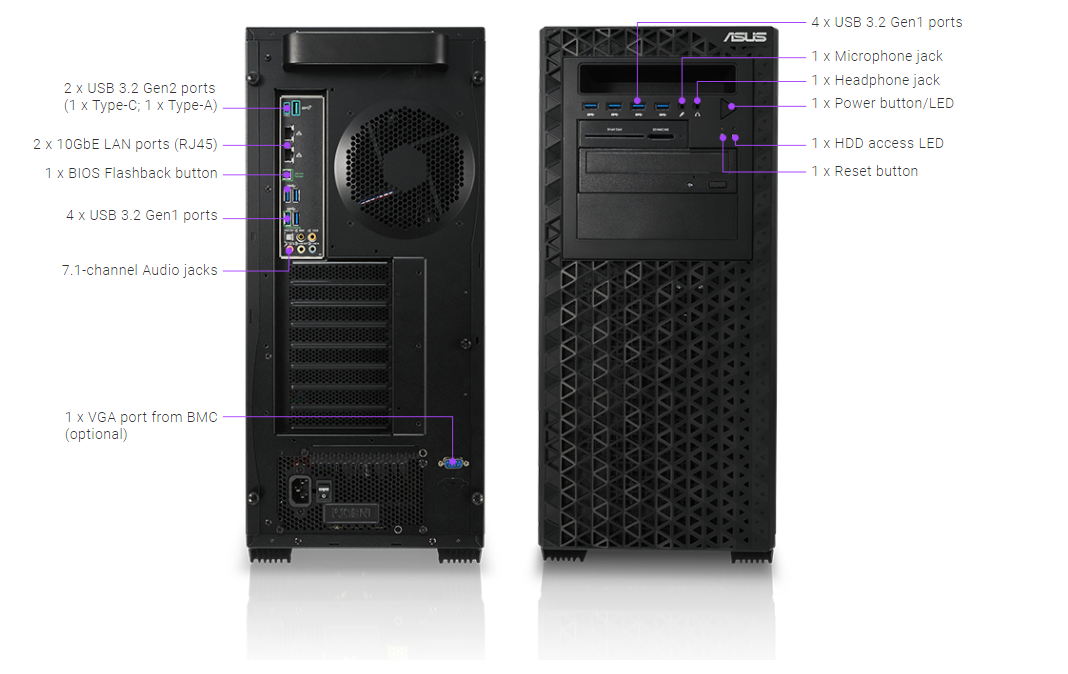

Asus Control Center o ACC es una plataforma de gestión centralizada para entornos de IT que permite la gestión y monitorización de servidores Asus, estaciones de trabajo y productos de gama consumer como portátiles, equipos de sobremesa, Pc´s All-in-one y cartelería digital.

El producto está diseñado para ser especialmente intuitivo y fácil de usar, y entre otras funciones permite el deployment de aplicaciones remotas, programar tareas de mantenimiento, monitorización hardware y software, y muchas más funciones imprescindibles para una gestión eficiente del entorno IT y datacenter. Algo muy interesante es que no sólo funciona con máquinas físicas, sino también con máquinas virtuales siendo compatible con Hypervisors como VMWare. Todo por supuesto gestionado de manera segura. En el momento de escribir este artículo existen 3 versiones de ACC, Classic, CSM y Enterprise, adaptados a las necesidades y tamaño de cualquier organización.

El funcionamiento de ACC está basada en unos agentes que se instalan y se ejecutan en los equipos que queremos gestionar. Estos agentes recolectan y registran información que podemos visualizar a través de una consola de gestión basada en web.

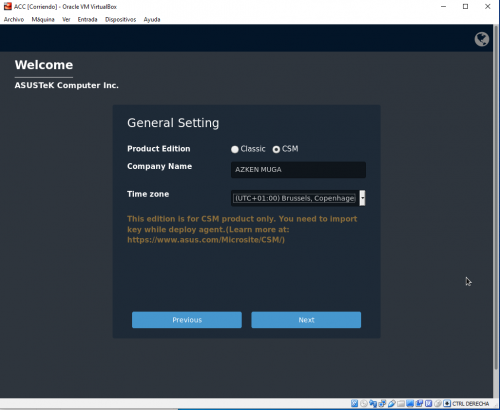

Para empezar lo primero que hay que hacer es poner en marcha ACC. Este primer paso es extraordinariamente sencillo y fácil, ya que ACC está basado en una máquina virtual VM Linux compatible con VMware, Hyper-V y Oracle VirtualBox que Asus suministra a través de una imagen OVA y que se puede poner en marcha en cualquier equipo que cumpla los requisitos mínimos de 4vCPU, 8GB de memoria RAM, 100GB de HD.

En nuestras pruebas decidimos usar Virtual Box por la inmediatez, facilidad de instalación y uso en cualquier equipo con Windows o Linux. Hemos seguido la documentación de Asus ACC, la cual está perfectamente detallada y funciona correctamente para instalar Oracle Virtual Box y poner en marcha ACC.

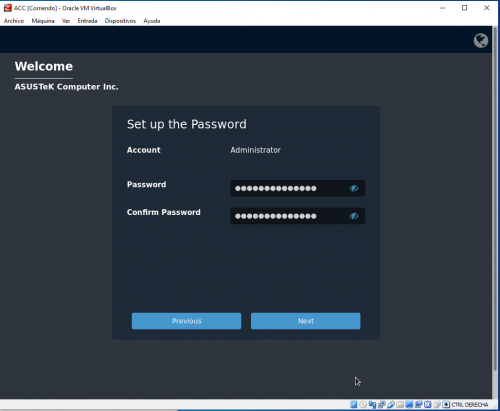

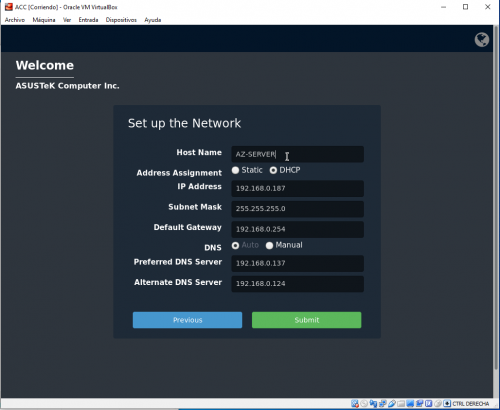

Una vez completado el setup inicial de la VM y el arranque, se ejecuta un asistente que nos permitirá realizar la configuración inicial básica, incluyendo datos como el nombre de la compañía, zona horaria, passwords de acceso y direcciones IP, tal y como vemos en las siguientes pantallas:

A partir de este momento ya somos capaces de acceder a ACC mediante cualquier navegador de internet y que nos permitirá acceder a todas las funciones de Asus ACC. Para acceder escribimos en la barra de direcciones del navegador la dirección IP o hostname con el siguiente formato, en nuestro caso:

Ojo que las mayúsculas de “ACC” son importantes.

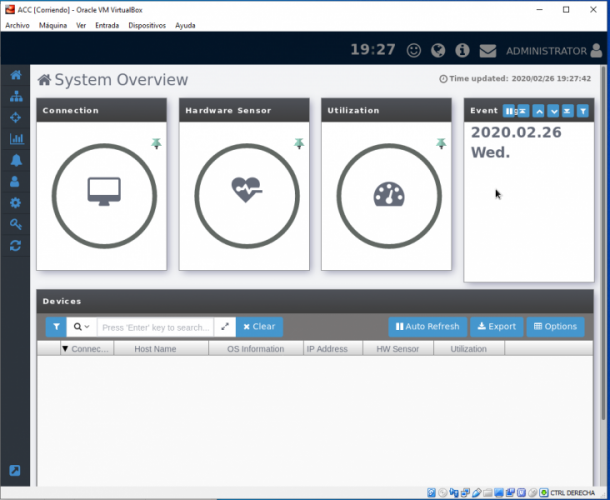

Como último paso antes de acceder a ACC, nos solicitará un usuario y un password. Una vez dentro visualizaremos una pantalla similar a esta, que es un resumen del sistema que estemos monitorizando:

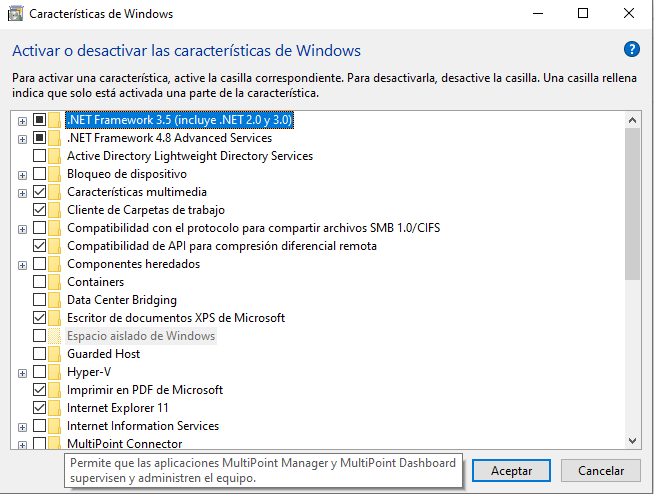

En este momento no veremos datos útiles, esto es normal ya que no hay sistemas que monitorizar, los cuales debemos ir añadiendo. Antes de añadir sistemas a ACC, es necesario prepararlos activando ciertas configuraciones de software muy sencillas como activar .NET framework 3.5 y algunos settings de compartición de ficheros e impresoras. Hay que tener en cuenta que ACC NO es compatible con sistemas Windows Home Edition o inferiores.

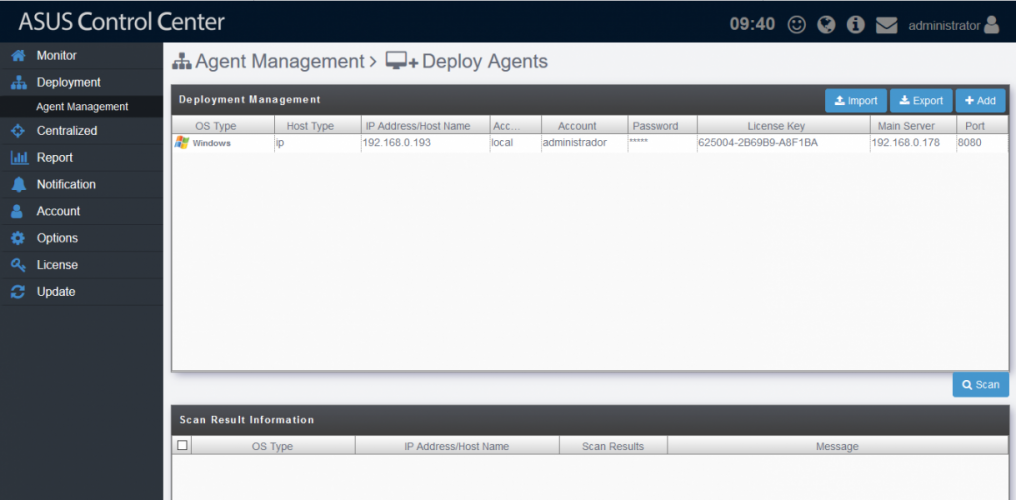

A continuación, podremos añadir equipos desde la pestaña “Deployment” y “Add”, seguimos los pasos y nuestros sistemas irán apareciendo en la consola, también podemos añadir muchos sistemas de una vez lo cual facilita enormemente los grandes deployments.

Como hemos dicho anteriormente, una parte muy interesante es la posibilidad de integrarlo en infraestructuras virtualizadas vía VMWare, esto lo podemos hacer desde la opción “Agentless Management”, aunque para tener disponible esta opción es necesario disponer de una licencia “Enterprise”.

A partir de este momento tendremos acceso a toda la potencia y versatilidad de la solución, algunos ejemplos:

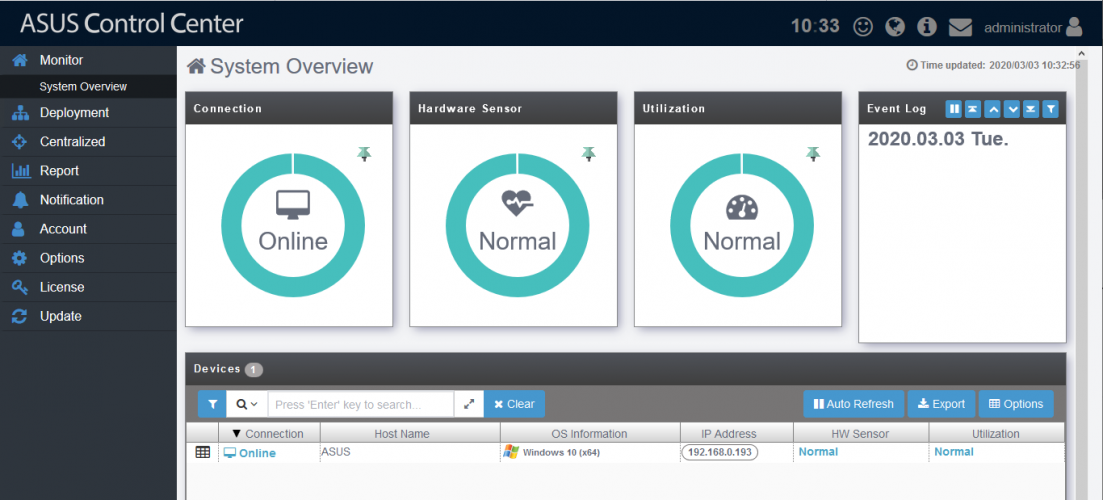

Overview general de una máquina:

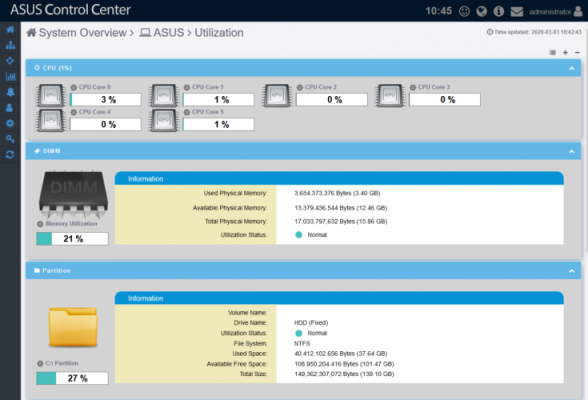

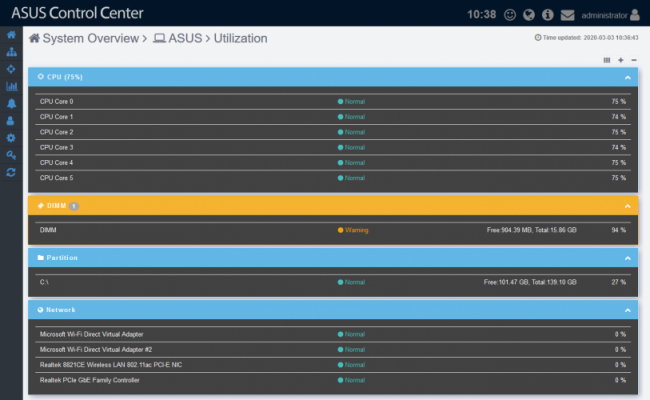

Información del estado de uso del hardware de manera gráfica e intuitiva:

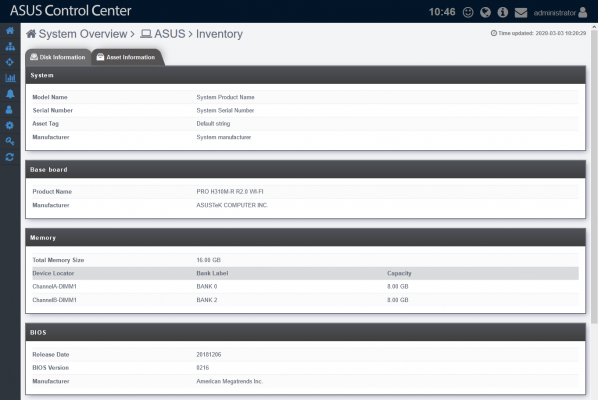

Gestión de inventario:

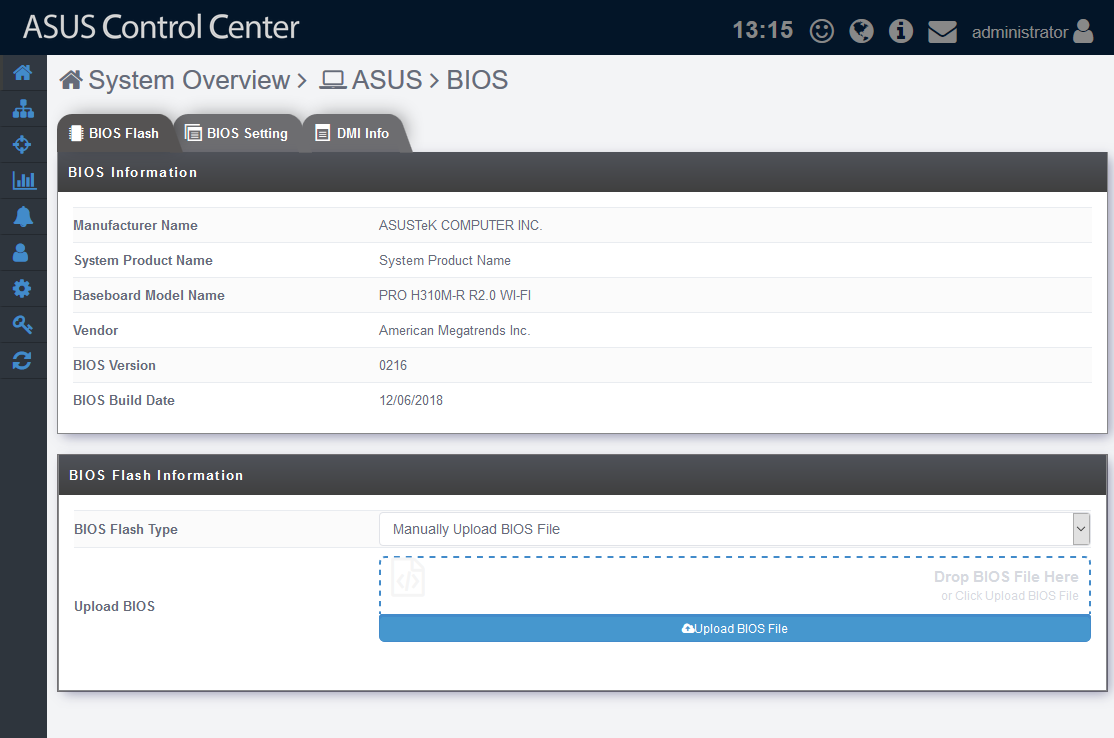

Actualización de BIOS:

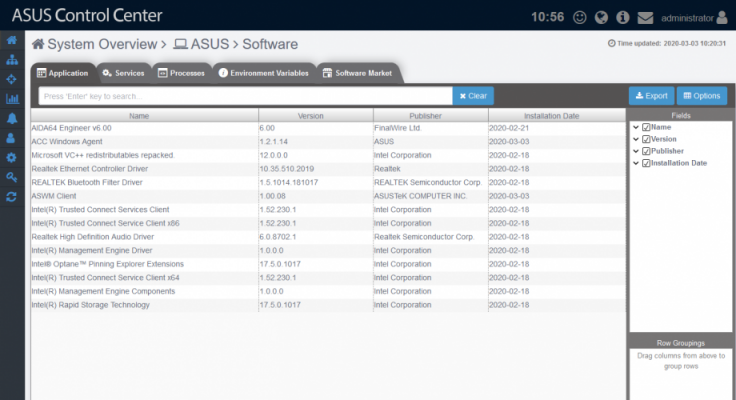

Gestión de software y servicios:

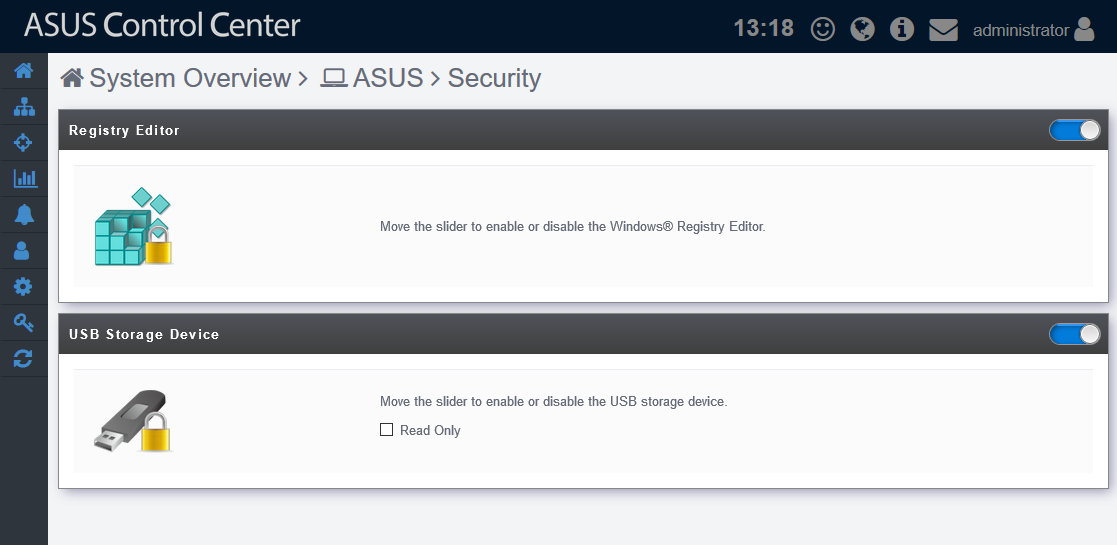

Funciones de seguridad como impedir el uso de USB o modificación del registro:

Y muchas más funciones necesarias para la gestión eficaz de infraestructura de IT.

Adicionalmente algunas posibilidades que lo hacen extremadamente atractivo por ejemplo para Datacenters es la integración con Intel Datacenter manager, que permite gestionar y programar el consumo de la infraestructura.